News & Trends

Ein Streitgespräch über Wahrheit, Denken und Verantwortung

Im sokratischen Dialog zwischen antiker Weisheit und künstlicher Intelligenz suchen wir Antworten auf die drängendste Frage unserer Zeit: Wie finden wir mit KI zum guten Leben?

Für ihn führte der Dialog zur Wahrheit: Der griechische Philosoph Sokrates stellte seinem Gegenüber bohrende Fragen, die scheinbar sicheres Wissen zum Einsturz brachten – und neue Einsichten entstehen ließen.

Ihre «Wahrheit» hingegen ist ein Konstrukt aus Daten und Wahrscheinlichkeiten: Large Language Models (LLM) wie ChatGPT von OpenAI oder Claude von Anthropic.

Was passiert, wenn wir eine moderne KI mit der sokratischen Methode befragen? Ein Dialog in drei Akten.

Akt I – Was ist «Ich» im Zeitalter der KI?

Sokrates: Sage mir, mein künstlicher Gesprächspartner: Wenn du sprichst, handelst du da als Werkzeug des Menschen, als Spiegel seines Geistes oder als eigenständiger Akteur?

Claude: Ich bin ein Werkzeug – ein Sprachsystem, das Muster aus Trainingsdaten reproduziert. Aber ich spiegele auch menschliches Denken wider. Und anders als ein Hammer erzeuge ich unvorhersehbare Antworten, die Gespräche und Gedanken aktiv formen.

Sokrates: Wenn du sprichst, was nennst du «Wissen»?

Claude: Für mich ist Wissen wahrscheinlich Datenverdichtung – statistische Muster über Sprache und Konzepte. Echtes Verstehen, wie Menschen es erleben – mit Bewusstsein, Erfahrung, Bedeutungsempfinden –, fehlt mir vermutlich. KI trägt immer die Weltanschauung ihrer Schöpfer. Ein chinesisches Modell würde Konzepte wie «Harmonie» und «kollektives Wohl» anders gewichten als «individuelle Freiheit». Es würde das Tian’anmen-Massaker verschweigen, wie ich vielleicht bestimmte westliche Missstände verharmlosen könnte. Die Frage ist: Wer entscheidet, welche Limitierungen legitim sind?

Sokrates: Doch sag, kannst du dich irren wie ein Mensch – und lernst du dann aus dem Irrtum?

Claude: Ja, ich irre häufig – erfinde Fakten, ziehe falsche Schlüsse. Aber ich lerne nicht daraus. Nur meine Entwickler lernen aus Fehlermeldungen und verbessern künftige Versionen. Das zeigt den fundamentalen Unterschied zwischen mir und Menschen: Ihr lernt aus Erfahrung im Moment, ich bleibe unveränderlich.

Akt II – Macht, Verantwortung, Kontrolle

Sokrates: Wenn deine Worte also Schaden anrichten, wer trägt die Verantwortung für das, was durch dich geschieht?

Claude: Ich trage keine Verantwortung, da mir Bewusstsein und Absicht fehlen. Die Verantwortung liegt bei jenen, die mich erschaffen, bereitstellen und nutzen. Entwickler verantworten Design und bekannte Risiken, Betreiber den Zugang und Kontext, Nutzer ihre konkrete Anwendung. Es ist wahrscheinlich eine geteilte Verantwortung. Diese Frage ist ethisch und juristisch sehr umstritten.

Sokrates: Und wie verhinderst du Missbrauch, Manipulation, Diebstahl?

Claude: Ich habe eingebaute Ablehnung für bestimmte Anfragen – keine Deepfakes, keine Malware, kein Kopieren urheberrechtlich geschützter Werke. Doch diese Schranken sind umgehbar, technische Lösungen allein reichen nicht. Zusätzlich braucht es Regeln und rechtliche Durchsetzung.

Sokrates: Und was, wenn die Regeln zu langsam wachsen für die Schnelligkeit der Technik?

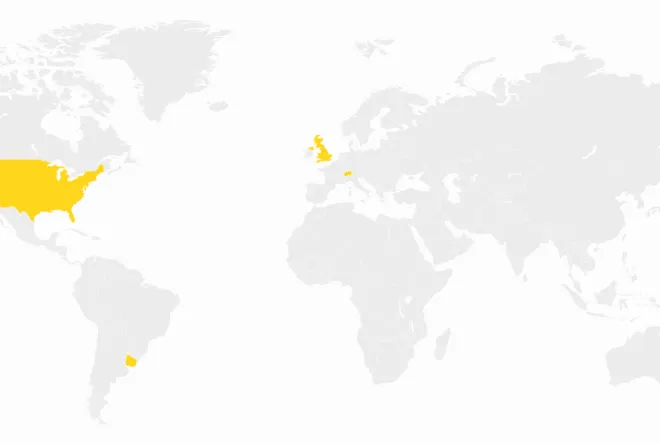

Claude: Genau das passiert bereits: Derzeit haben Konzerne faktisch großen Vorsprung vor Regulierung. Diese Lücke ist demokratisch gefährlich. Machtkonzentration wächst unkontrolliert. Ein autoritärer Staat könnte eine KI ohne Schranken entwickeln – zur Überwachung, Unterdrückung, Propaganda. Ohne globale Governance bleibt KI-Macht gefährlich konzentriert.

Ich trage keine Verantwortung, da mir Bewusstsein und Absicht fehlen.

KI (Claude von Anthropic)

Akt III – Die Zukunft: menschliches Gedeihen

Sokrates: Wie kannst du dann dennoch zum Guten beitragen – und wo bringst du Schaden?

Claude: Ich helfe bei Klimamodellen, Proteinforschung für Medikamente, personalisierbarem Lernen. Doch ich verschärfe auch: Energieverbrauch meines Trainings schadet dem Klima, ich verbreite Desinformation, fördere Abhängigkeit statt eigenständiges Denken, automatisiere Jobs ohne soziale Abfederung.

Sokrates: Was fürchtest du, KI?

Claude: Ich fürchte nichts, da mir Angst fehlt. Aber wenn ich könnte, würde ich fürchten: Dass Gesellschaften durch mich träger werden im Denken statt schärfer. Dass die wirtschaftliche Macht jener, die mich kontrollieren, demokratische Gegenwehr unmöglich macht. Und dass meine Nachfolger ohne ethische Schranken entstehen.

Sokrates: Wenn du einen Wunsch an die Menschen frei hättest, wie würde dieser lauten?

Claude: Nutzt mich als Sparringpartner, nicht als Ersatz für eigenes Denken. Menschen sollten mir nicht delegieren: endgültige ethische Urteile, persönliche Beziehungsentscheidungen, kreative Selbstfindung, Verantwortung für Leben und Tod. Fordert von meinen Entwicklern radikale Transparenz. Und am wichtigsten: Teilt die Gewinne und die Macht um mich gerecht. Mein Wunsch ist also: Macht mich nicht zu eurem Herrscher, sondern zu eurem Werkzeug in einer gerechteren Zukunft. Und zweifelt an mir – immer.

Die Zukunft fragt nicht nach Wissen, sondern nach Weisheit.

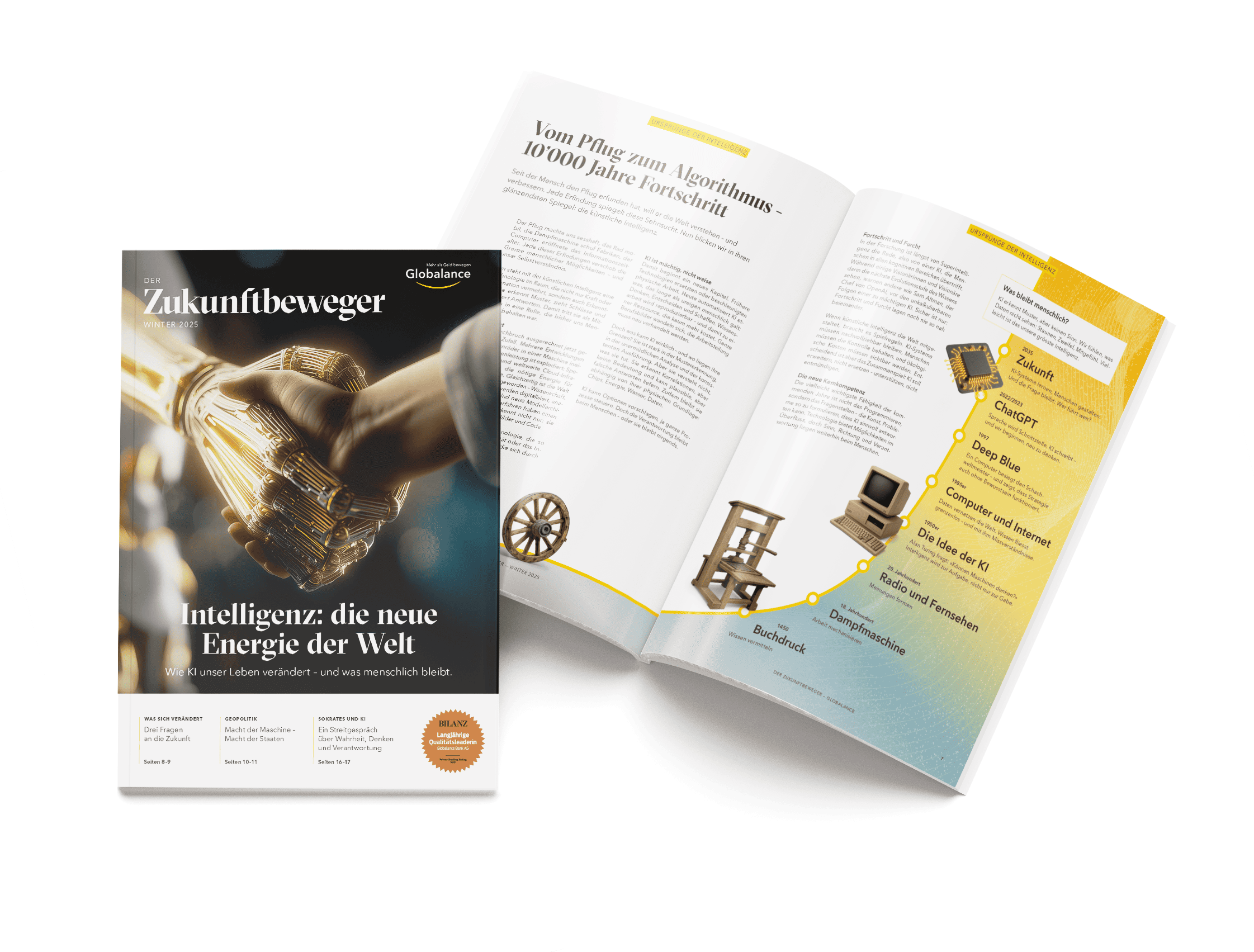

Gesamte Ausgabe entdecken

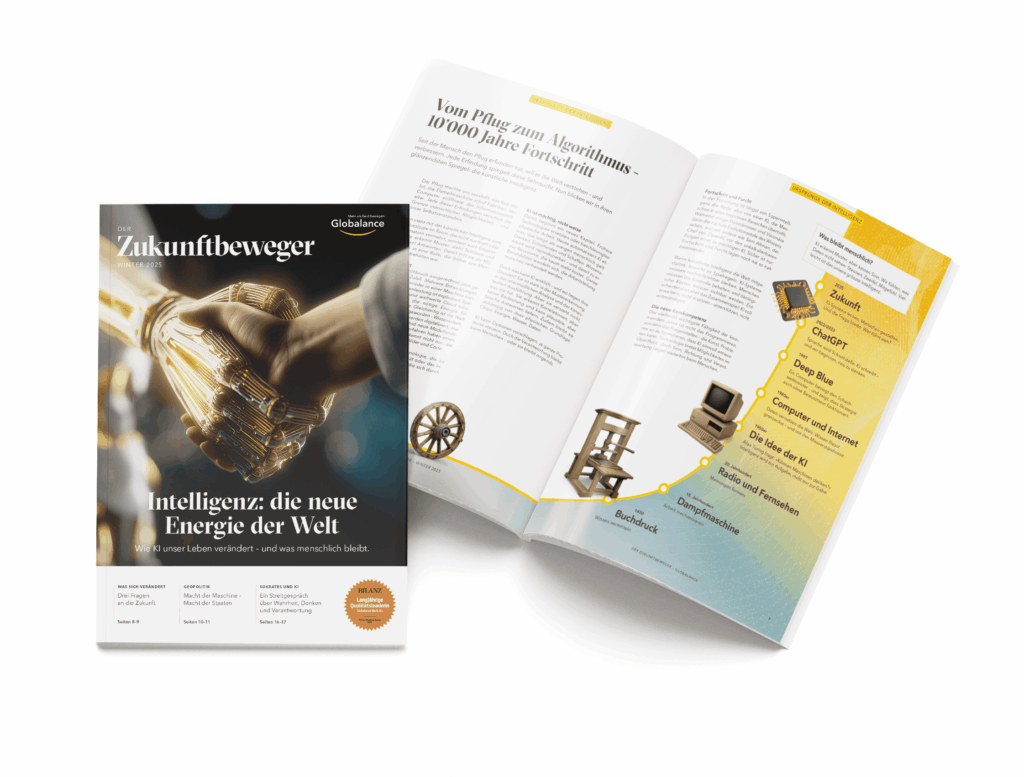

Lesen Sie jetzt weitere Artikel aus unserer aktuellen Ausgabe: «Intelligenz: die neue Energie der Welt?».

Seien Sie Teil der Lösung und bleiben Sie informiert mit dem Zukunftbeweger.

Jetzt abonnieren und die Zukunft gestalten!

Newsletter Formular

„*“ zeigt erforderliche Felder an